Wie schlägt sich der neue MacMini mit Apple M4 CPU gegen einen Intel PC mit NVidia RTX-3070 GPU, wenn es um das Thema KI geht? Dieser Artikel zeigt den direkten Vergleich.

MacMini M4 im Test: Das Setup

Unser KI Test-Szenario besteht aus dem folgenden Setup:

- Getestet wird ein Mac Mini M4 mit 24 GB RAM, mit 10 Core CPU, 10 Core GPU, 16 Core Neural Engine, 120 GB/s RAM Bandwidth, macOS 15.

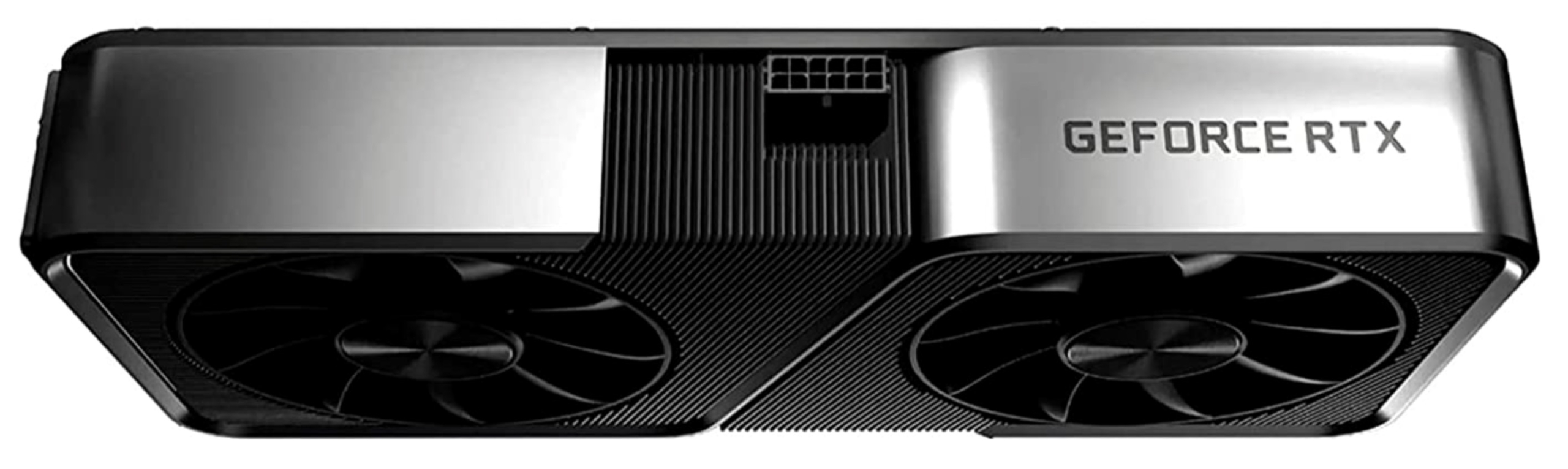

- Der Gegner: Ein PC mit Intel Core i7-10700 und NVidia Geforce RTX-3070 GPU. Die GPU hat 5.888 CUDA-Cores, 184 Tensor Cores, 448 GB/s RAM Bandwidth, 8 GB VRAM und läuft unter Windows 11 Pro 24H2.

- Die Software ist Ollama mit folgenden LLMs: Qwen2.5-Coder:7b, 14b und 32b sowie LLama3.2:3b

Die Aufgabe für das LLM: “Schreibe einen Websocket Server in C#”:

|

1 2 |

ollama run llama3.2:latest --verbose >>> Schreibe einen Websocket Server in C# |

Der Wichtigste Parameter ist die Eval-Rate am Ende der Ausgabe. Alles was >= 10 Token pro Sekunde ist, wird vom Benutzer beim Lesen noch als akzeptabel empfunden. Werte darunter als zu langsam.

MacMini M4 vs. NVidia Geforce RTX-3070: Die Ergebnisse

LLama3.2:3b (2.0 GB)

MacMini M4:

|

1 2 3 4 5 6 7 8 |

total duration: 17.7778915s load duration: 25.402583ms prompt eval count: 32 token(s) prompt eval duration: 199ms prompt eval rate: 160.80 tokens/s eval count: 717 token(s) eval duration: 17.552s eval rate: 40.85 tokens/s |

PC mit NVidia Geforce RTX-3070:

|

1 2 3 4 5 6 7 8 |

total duration: 7.8433312s load duration: 18.9959ms prompt eval count: 35 token(s) prompt eval duration: 850ms prompt eval rate: 41.18 tokens/s eval count: 613 token(s) eval duration: 6.962s eval rate: 88.05 tokens/s |

Mit dem Ergebnis von fast 90 Token pro Sekunde ist die NVidia Geforce RTX-3070 mehr als doppelt so schnell wie der MacMini M4. Die Ausgabe des MacMini mit knapp 41 Token pro Sekunde ist jedoch flüssig und somit OK.

Qwen2.5-Coder:7b (4.7 GB)

MacMini M4:

|

1 2 3 4 5 6 7 8 |

total duration: 43.016241625s load duration: 22.598166ms prompt eval count: 36 token(s) prompt eval duration: 375ms prompt eval rate: 96.00 tokens/s eval count: 875 token(s) eval duration: 42.456s eval rate: 20.61 tokens/s |

PC mit NVidia Geforce RTX-3070:

|

1 2 3 4 5 6 7 8 |

total duration: 15.4515554s load duration: 18.5058ms prompt eval count: 39 token(s) prompt eval duration: 1.165s prompt eval rate: 33.48 tokens/s eval count: 785 token(s) eval duration: 13.999s eval rate: 56.08 tokens/s |

Trotz komplexerem LLM bleibt der Abstand ungefähr gleich: Die NVidia RTX-3070 ist mehr als doppelt so schnell als der MacMini M4. Mit knapp 21 Token pro Sekunde ist der M4 in dieser Kategorie als KI-Maschine noch gut geeignet.

Qwen2.5-Coder:14b (9 GB)

MacMini M4:

|

1 2 3 4 5 6 7 8 |

total duration: 1m30.197150625s load duration: 27.20875ms prompt eval count: 39 token(s) prompt eval duration: 259ms prompt eval rate: 150.58 tokens/s eval count: 972 token(s) eval duration: 1m29.908s eval rate: 10.81 tokens/s |

PC mit NVidia Geforce RTX-3070:

|

1 |

N/A |

Mit knapp über 10 Token pro Sekunde in dieser Kategorie ist der M4 als KI-Maschine immer noch brauchbar. Die NVidia Geforce RTX-3070 hingegen muss hier leider geschlagen geben, da sie nur LLMs verarbeiten kann, die in den 8 GB VRAM-Speicher passen.

Qwen2.5-Coder:32b (20 GB)

MacMini M4:

|

1 2 3 4 5 6 7 8 |

total duration: 4m47.733996s load duration: 23.813958ms prompt eval count: 36 token(s) prompt eval duration: 24.238s prompt eval rate: 1.49 tokens/s eval count: 1093 token(s) eval duration: 4m23.304s eval rate: 4.15 tokens/s |

PC mit NVidia Geforce RTX-3070:

|

1 |

N/A |

Hier ist der M4 mit 4 Token pro Sekunde deutlich zu langsam, jedoch trotzdem für Experimente geeignet, bei denen Geschwindigkeit keine primäre Rolle spielt. Die NVidia Geforce RTX-3070 hingegen muss hier leider ebenfalls passen.

Apple M4 vs NVidia Geforce RTX-3070: Das Fazit

Wer eine vergleichsweise günstige KI-Maschine für LLMs bis ca. 14 Billionen Parameter sucht, sollte zum MacMini M4 in der Grundausstattung greifen. Mit 700 EUR inkl. Mwst liegt der Preis des MacMini M4 bei ca. 40-50% der Intel-Maschine mit Geforce RTX-3070.

Mit gebrauchten Komponenten und Eigenbau, lässt sich der Preis für ein System mit der NVidia RTX-3070 vielleicht sogar an den des MacMini annähern.

Spielt hingegen Geschwindigkeit eine Rolle, dann schlägt erst der M4 Max des MacBookPro 2024 die NVidia Geforce RTX-3070. Sowohl bei Token/s (ca. 15-20% mehr Leistung) als auch bei der max. Größe des LLM, die beim M4 Max nur durch den Gesamtspeicher limitiert ist. Doch da sind wird wieder in ganz anderen preislichen Regionen …

Einen ebenfalls sehr interessanten Vergleich zwischen dem MacMini M4 und dem Apple M1 Max findest Du hier.