Wie schlägt sich der aktuelle MacMini mit Apple M4 CPU gegen das NVidia Jetson Orin Nano Super Developer Kit bei KI-Anwendungen? Dieser Artikel zeigt den direkten Vergleich.

MacMini M4 im Test: Das Setup

Unser KI Test-Szenario besteht aus dem folgenden Setup:

MacMini M4

Getestet wird ein Mac Mini M4 mit 24 GB RAM, mit 10 Core CPU, 10 Core GPU, 16 Core Neural Engine, 120 GB/s RAM Bandwidth, macOS 15.

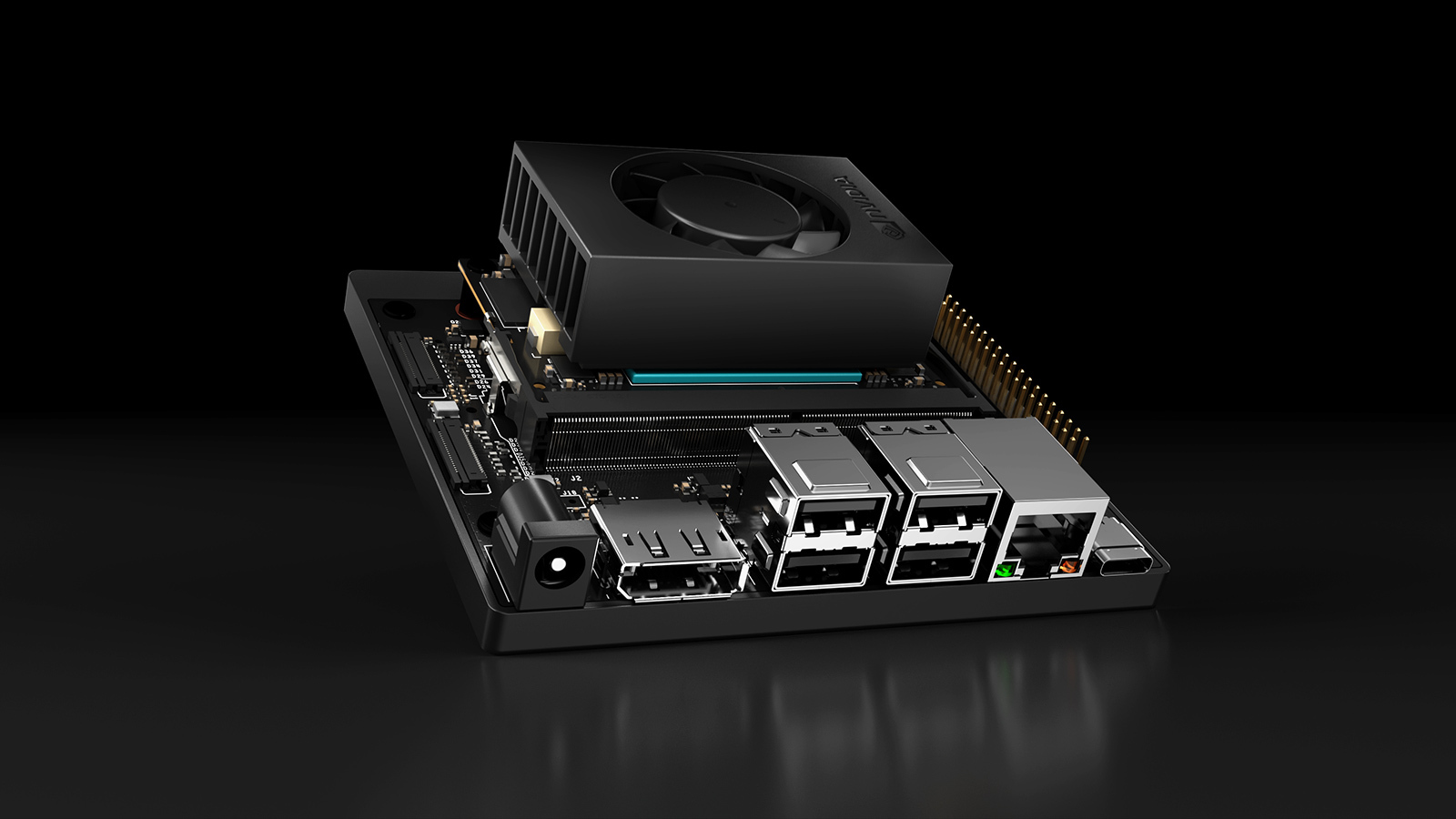

NVidia Jetson Orin Nano

Der Gegner: Das NVidia Jetson Orin Nano Super Developer Kit. Die CPU ist ein 6-core ARM Cortex-A78AE v8.2 64-bit Prozessor, die GPU hat 1024 CUDA-Cores mit 32 Tensor-Kernen. Der Jetson Orin Nano hat 8 GB RAM (128-bit LPDDR5) mit lediglich 102 GB/s Bandwidth und läuft unter einem modifizierten Ubuntu Linux 22.04.

Die geringe Bandbreite spielt hier nur eine untergeordnete Rolle, da das LLM komplett in die GPU des NVidia Jetson Orin Nano geladen wird.

Für den Test wurde Ollama auf dem Jetson Orin Nano wie folgt installiert und nicht per Docker-Container verwendet:

|

1 |

curl -fsSL https://ollama.com/install.sh | sh |

Software

Die Software ist Ollama mit folgenden LLMs: Qwen2.5-Coder:7b und LLama3.2:3b

Die Aufgabe für das LLM: “Schreibe einen Websocket Server in C#”:

|

1 2 |

ollama run llama3.2:latest --verbose >>> Schreibe einen Websocket Server in C# |

Der Wichtigste Parameter ist die Eval-Rate am Ende der Ausgabe. Alles was >= 10 Token pro Sekunde ist, wird vom Benutzer beim Lesen noch als akzeptabel empfunden. Werte darunter in der Regel als zu langsam.

MacMini M4 vs. NVidia Jetson Orin Nano Super Developer Kit: Die Ergebnisse

LLama3.2:3b (2.0 GB)

MacMini M4:

|

1 2 3 4 5 6 7 8 |

total duration: 17.7778915s load duration: 25.402583ms prompt eval count: 32 token(s) prompt eval duration: 199ms prompt eval rate: 160.80 tokens/s eval count: 717 token(s) eval duration: 17.552s eval rate: 40.85 tokens/s |

NVidia Jetson Orin Nano Super Developer Kit:

|

1 2 3 4 5 6 7 8 |

total duration: 38.11786158s load duration: 202.720964ms prompt eval count: 90 token(s) prompt eval duration: 85.127281ms prompt eval rate: 1057.24 tokens/s eval count: 833 token(s) eval duration: 36.801642824s eval rate: 22.63 tokens/s |

Mit dem Ergebnis von fast 23 Token pro Sekunde ist der NVidia Jetson Orin etwas mehr als halb so schnell wie der MacMini M4. Die Ausgabe beider Probanten läuft jedoch flüssig, in angenehmer Geschwindigkeit.

Qwen2.5-Coder:7b (4.7 GB)

MacMini M4:

|

1 2 3 4 5 6 7 8 |

total duration: 43.016241625s load duration: 22.598166ms prompt eval count: 36 token(s) prompt eval duration: 375ms prompt eval rate: 96.00 tokens/s eval count: 875 token(s) eval duration: 42.456s eval rate: 20.61 tokens/s |

NVidia Jetson Orin Nano Super Developer Kit:

|

1 2 3 4 5 6 7 8 |

total duration: 45.339605764s load duration: 162.91938ms prompt eval count: 39 token(s) prompt eval duration: 209.58978ms prompt eval rate: 186.08 tokens/s eval count: 514 token(s) eval duration: 44.210885546s eval rate: 11.63 tokens/s |

Auch hier ist der NVidia Jetson Orin Nano mit lediglich knapp 12 Token/s etwas mehr als halb so schnell wie der Mac Mini M4. Die Ausgabe ist auf beiden Geräten noch flüssig.

Was ist mit größeren Large Language Models?

Bei beiden Maschinen wird die Größe der LLMs nur durch das verfügbare RAM limitiert. D.h. der MacMini M4 kann in dieser Konfiguration LLMs bis ca. 20 GB ausführen, der NVidia Jetson Orin Nano jedoch nur LLMs bis ca. 6.5 GB Größe. Versucht man beim Jetson Orin Nano größere Modelle zu laden, kommt es zum Crash.

Paralleles Verarbeiten von LLM-Requests

Ein weiterer Aspekt ist das parallele Verarbeiten von LLM-Anfragen, wenn man die Maschine als Ollama-Server verwenden möchte. Was beim MacMini M4 kein Problem ist, stößt beim Jetson Orin Nano leider auf eine Einschränkung:

Aufgrund des geringen Speichers können LLM-Requests nicht parallel ausgeführt werden können. Statt dessen landen die Requests in einer Queue und werden nacheinander behandelt. D.h. der nächste Request bekommt erst eine Antwort, wenn die vorherige Frage und die eigene Frage vom LLM komplett beantwortet wurden.

Apple M4 vs NVidia Jetson Orin Nano: Das Fazit

Wenn Du eine extrem günstige KI-Maschine für LLMs bis ca. 8 Billionen Parameter und einer maximalen Größe von ca. 6.5 GB suchst und parallel Processing keine Rolle spielt, solltest Du zum NVidia Jetson Orin Nano greifen.

Trotzdem liefert der Jetson Orin Nano eine für den Preis beachtliche Leistung. Günstiger kann man in die Welt der KI und LLM-Technologie kaum einsteigen.

Mit ca. 300-330 EUR für das Board + ca. 20 EUR für ein passendes Gehäuse, liegt der Preis des NVidia Jetson Orin Nano bei nur ca. 45% der Kosten für den MacMini M4 (ca. 700 EUR).

Für größere LLMs, mehr Speed und parallel Processing ist der MacMini M4 die bessere Wahl. Wie der Preis schon vermuten lässt: Der MacMini M4 ist zwar doppelt so teuer wie der Jetson Orin Nano, aber auch doppelt so schnell.

Lies weitere KI-Tests mit dem MacMini M4: