Über das gratis Continue-Plugin lassen sich alle JetBrains IDEs mit einer kostenlosen AI nachrüsten. Das funktioniert z.B. mit PhpStorm, PyCharm, GoLand und weiteren IDEs von JetBrains.

JetBrains IDE mit eigener KI: Die Systemvoraussetzungen

Voraussetzung ist ein Mac mit Apple Silicon oder ein Windows PC mit einer Nvidia RTX-3060 GPU oder höher mit mind. 8 GB VRAM. Hat man noch einen alten Mac mit Intel CPU und einen entsprechenden PC im Netz, lässt sich der KI Task auch auf den PC delegieren. Die benötigten LLMs und Embeddings werden lokal installiert, d.h. die Abfragen sind extrem schnell und alle Daten bleiben im eigenen Netz.

Was kann der kostenlose Continue Code-Assistent?

Die KI ergänzt die JetBrains IDE um die folgenden Funktionen:

- Code-Generator: Die KI generiert beliebigen Code aufgrund einer Beschreibung in natürlicher Sprache.

- Code-Rewrite: Code kann von einer Programmiersprache in eine andere konvertiert werden.

- Code-Optimization: Markierte Code-Abschnitte können optimiert oder automatisch kommentiert werden.

- Reverse-Engineering: Die Bedeutung eines Code Abschnitts wird erläutert.

- Full Line- und Multi Line Code-Completition: Die KI macht beim Tippen Vorschläge für die restliche Zeile oder sogar mehrere Zeilen.

Darüber hinaus können Custom Commands angelegt werden um z.B. automatische Unit Tests zu generieren oder andere Dinge zu automatisieren.

Hier ein Beispiel zum Code-Generator:

Reverse-Engineering:

Code-Optimization:

JetBrains IDE: Den kostenlosen AI Assistenten einrichten

Zuerst installieren wir Ollama über ollama.com.

Per Kommandozeile installieren wir dann die entsprechenden LLMs und Embeddings:

|

1 2 3 |

ollama pull llama3.1:latest ollama pull starcoder2:3b ollama pull nomic-embed-text:latest |

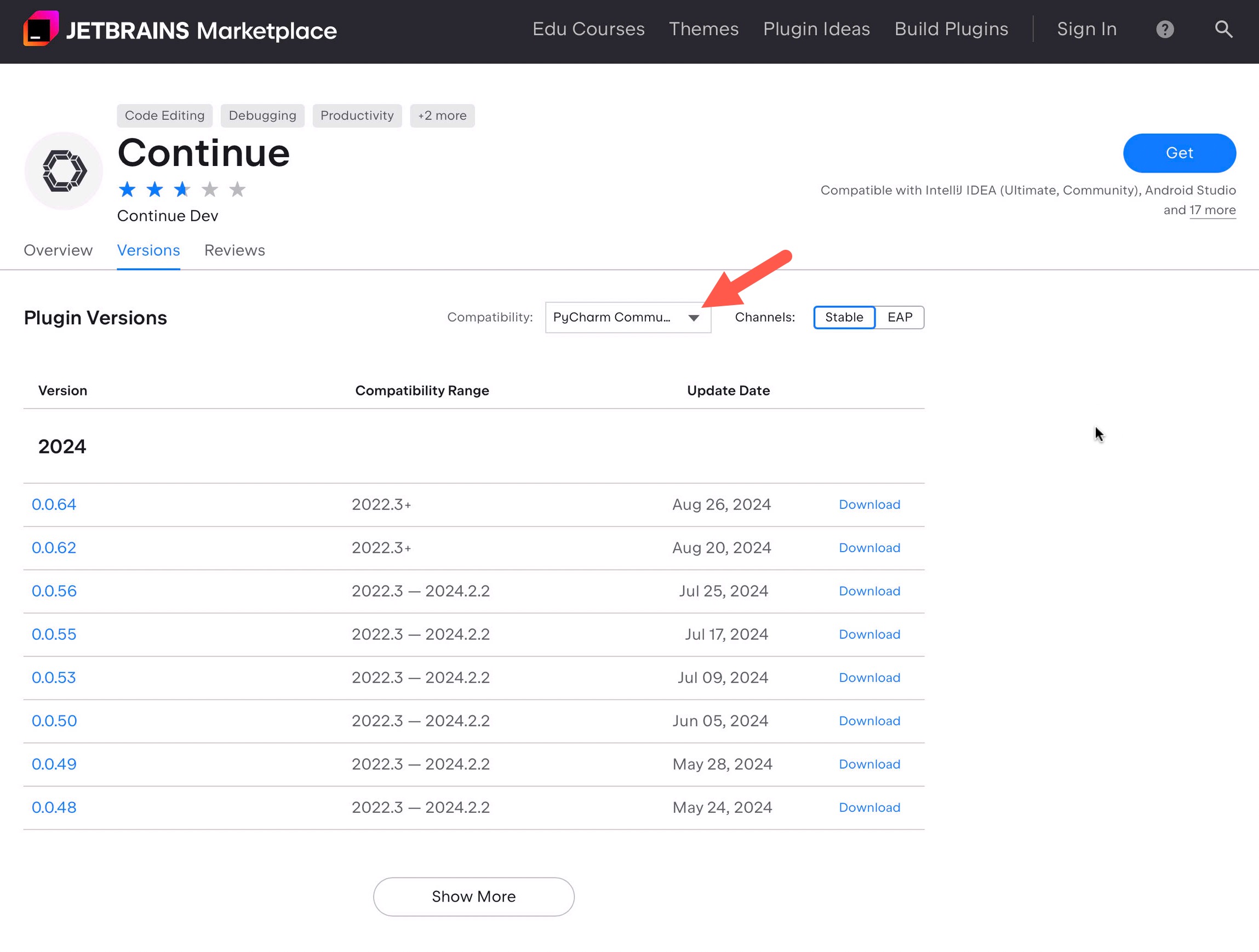

Über die folgende URL rufen wir den JetBrains Plugin Marketplace auf und geben in der Suchmaske “Continue” ein.

Danach filtern wir die Releases nach unserer IDE. Über den GET-Button laden wir die aktuellste Version:

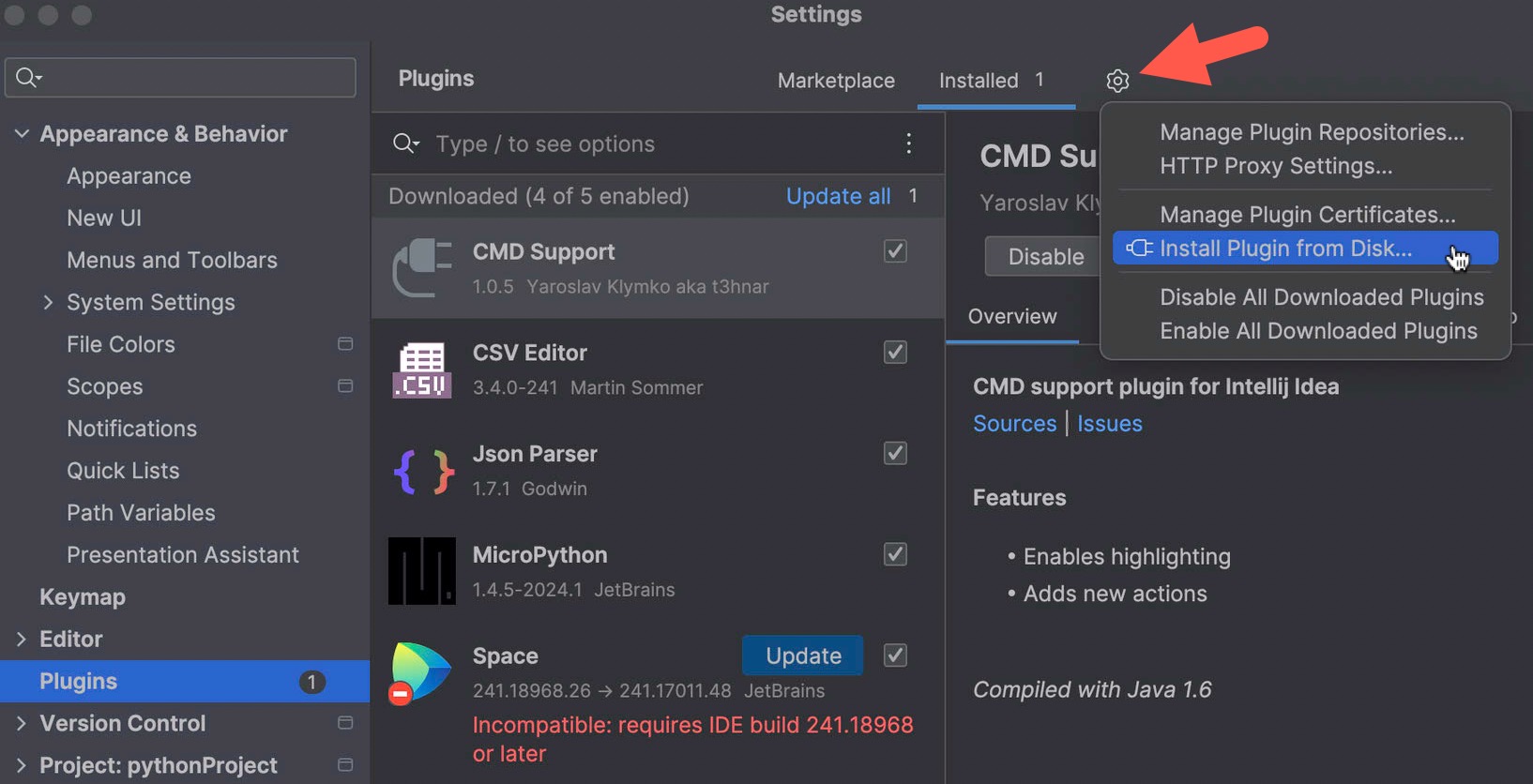

Wir wechseln in unsere IDE (hier PyCharm) und installieren das Plugin über PyCharm/Settings/Plugins und wählen dort “Install Plugin from Disk”:

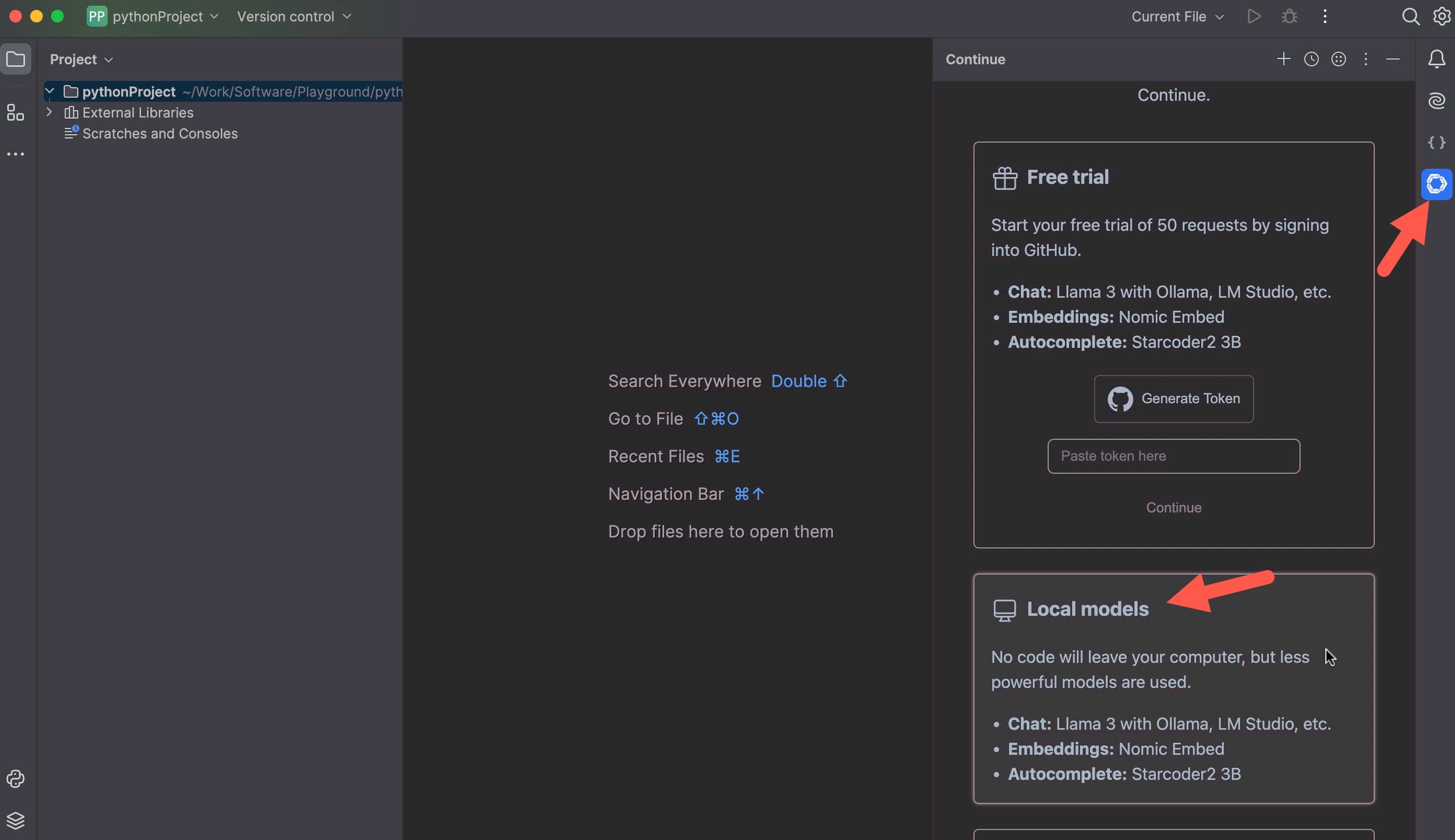

Nach Installation klicken wir am rechten Rand auf das Continue-Icon und wählen “Local Models”:

Dann scrollen wir ganz nach unten und klicken auf “Continue”.

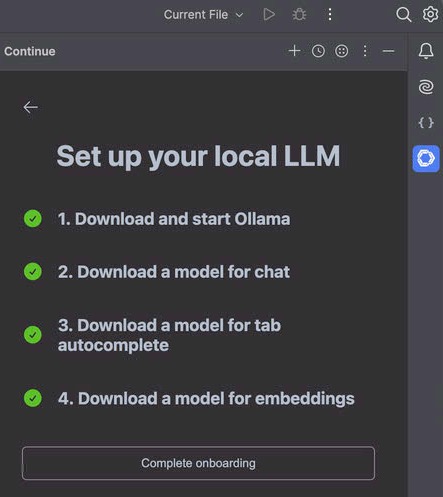

Wenn wir am Anfang alles richtig gemacht haben ist die folgende Checkliste komplett und das Onboarding damit abgeschlossen. Wir bestätigen mit “Complete onboarding”. Sollten noch Punkte offen sein, liefert Continue die entsprechenden Terminal-Kommandos per Copy/Paste über die Zwischenablage:

Unser kostenloser AI Code-Assistent ist nun startklar :-)

Meine Developer Maschine hat keine passende CPU oder GPU. Kann ich die KI trotzdem nutzen?

Ja, wenn ein kompatibler Mac oder PC im Netz existiert, kann der KI-Task dort hin delegiert werden.

Dazu installieren wir auf der Dev-Box lediglich Ollama und das Embedding.

|

1 |

ollama pull nomic-embed-text |

Auf unserem Server installieren wir eine weitere Instanz von Ollama und die LLMs:

|

1 2 |

ollama pull llama3.1:latest ollama pull starcoder2:3b |

Dann klicken wir in der Seitenleiste des Plugins unten rechts auf das Zahnrad und überschreiben die JSON-Config mit dem folgenden Inhalt:

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 |

{ "models": [ { "model": "llama3.1:latest", "title": "Ollama (Remote)", "completionOptions": {}, "apiBase": "http://192.168.0.20:11434", "provider": "ollama" } ], "customCommands": [], "tabAutocompleteModel": { "title": "Starcoder 3b", "provider": "ollama", "apiBase": "http://192.168.0.20:11434", "model": "starcoder2:3b" }, "allowAnonymousTelemetry": false, "embeddingsProvider": { "provider": "ollama", "model": "nomic-embed-text" } } |

In diesem Beispiel läuft Ollama auf einem Rechner mit der IP 192.168.0.20. Port 11434 muss in der Firewall des Servers freigeschaltet sein.

Die komplette Anleitung zu Continue findest Du hier.

Happy Coding :-)