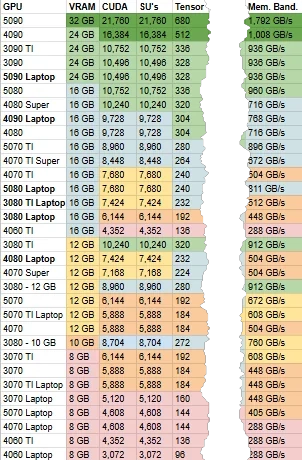

CUDA- und Tensor Cores sind Hardware-Komponenten, die bei der Ausführung von Large Language Modellen (LLMs) auf NVidia Grafikkarten (GPU) eine entscheidende Rolle spielen. Bei KI-Systemen mit NVidia GPUs, sind die Anzahl von CUDA- und Tensor Cores immer die beiden Haupt-Leistungsparameter, gefolgt von VRAM-Bandbreite und der Gesamtgröße VRAM.

Was sind CUDA Cores?

CUDA (Compute Unified Device Architecture) ist ein Framework von NVIDIA, das es ermöglicht, die GPU (Graphical Processing Unit) als parallelen Rechensystem zu nutzen. CUDA Cores stellen die grundlegenden Einheiten dar, auf denen CUDA-Programme ausgeführt werden.

In einem modernen Grafikkarten-Chip befindet sich eine große Anzahl von CUDA-Kernen. Diese Kerne können parallel miteinander arbeiten und ermöglichen es, komplexe Berechnungen sehr schnell durchzuführen. In Bezug auf LLMs spielen die CUDA Cores eine entscheidende Rolle bei der Ausführung von Trainings- und Inferenz-Algorithmen.

Was sind Tensor Cores?

Vereinfacht ausgedrückt, beschreibt ein Tensor mathematisch einen Punkt in einem Raum. Mehrere Tensoren lassen sich zu Feldern (Matrix) zusammenfassen in denen Vector-Informationen gespeichert werden. Large Language Models (LLMs) benötigen diese Strukturen um zu entscheiden wie nahe verschiedene Begriffe sprachlich und inhaltlich beieinander liegen.

Tensor Cores sind eine spezielle Hardware-Komponente, die im Rahmen des NVIDIA-TensorRT-Frameworks entwickelt wurde. Tensor Cores bieten eine erhebliche Steigerung der Leistung bei der Ausführung von Matrix-Operationen und anderen Tensor-basierten Berechnungen.

Im Kontext von LLMs nutzen Tensor Cores das Konzept von “Tensor-Kernen”, um komplexe Berechnungen sehr schnell durchzuführen. Durch die Verwendung von Tensor Cores kann die Ausführungszeit von Trainings- und Inferenz-Algorithmen erheblich reduziert werden. Inferenz bezeichnet in der KI-Forschung Algorithmen zur Schlußfolgerung eines Ergebnisses aus Benutzer-Eingabe (Prompt), vorheriger Konversationen (Kontext) und einer auf Vectoren basierender Datenbasis (LLM).

Wie funktionieren CUDA Cores und Tensor Cores in Bezug auf LLMs?

Bei der Implementierung von LLMs auf einer NVIDIA-GPU spielen CUDA Cores und Tensor Cores eine entscheidende Rolle. Die CUDA-Kerne arbeiten parallel miteinander, um die Trainings- oder Inferenz-Algorithmen auszuführen. Die Tensor Cores werden in diesem Zusammenhang verwendet, um Matrix-Operationen und andere tensor-basierte Berechnungen sehr schnell durchzuführen.

Durch die Kombination von CUDA Cores und Tensor Cores kann die Leistung von LLMs erheblich gesteigert werden. Dies ist besonders wichtig bei der Ausführung von komplexen Trainings- und Inferenz-Algorithmen.

Die folgende Tabelle zeigt eine Übersicht verschiedener NVidia Grafikkarten mit der jeweiligen Anzahl an CUDA-Cores, Tensor-Cores, Größe VRAM und Memory Bandwidth:

Welche Vorteile bieten CUDA Cores und Tensor Cores für LLMs?

Die Verwendung von CUDA Cores und Tensor Cores bietet mehrere Vorteile im Kontext von LLMs:

- Erhebliche Leistungssteigerung: Durch die Kombination von CUDA Cores und Tensor Cores kann die Ausführungszeit von Trainings- und Inferenz-Algorithmen erheblich reduziert werden.

- Verbesserter Rechenaufwand: Die parallele Ausführung von CUDA-Kernen ermöglicht es, komplexe Berechnungen sehr schnell durchzuführen.

- Erweiterbare Architektur: Das Framework von NVIDIA ermöglicht es, die Hardware-Architektur leicht zu erweitern und an das spezifische Problem anzupassen.

Insgesamt bietet die Kombination von CUDA Cores und Tensor Cores eine effiziente Lösung für die Implementierung von LLMs. Durch die Verwendung dieser Hardware-Komponenten können Entwickler komplexe Trainings- und Inferenz-Algorithmen sehr schnell durchführen, was zu einer erheblichen Steigerung der Leistung bei LLMs führt.